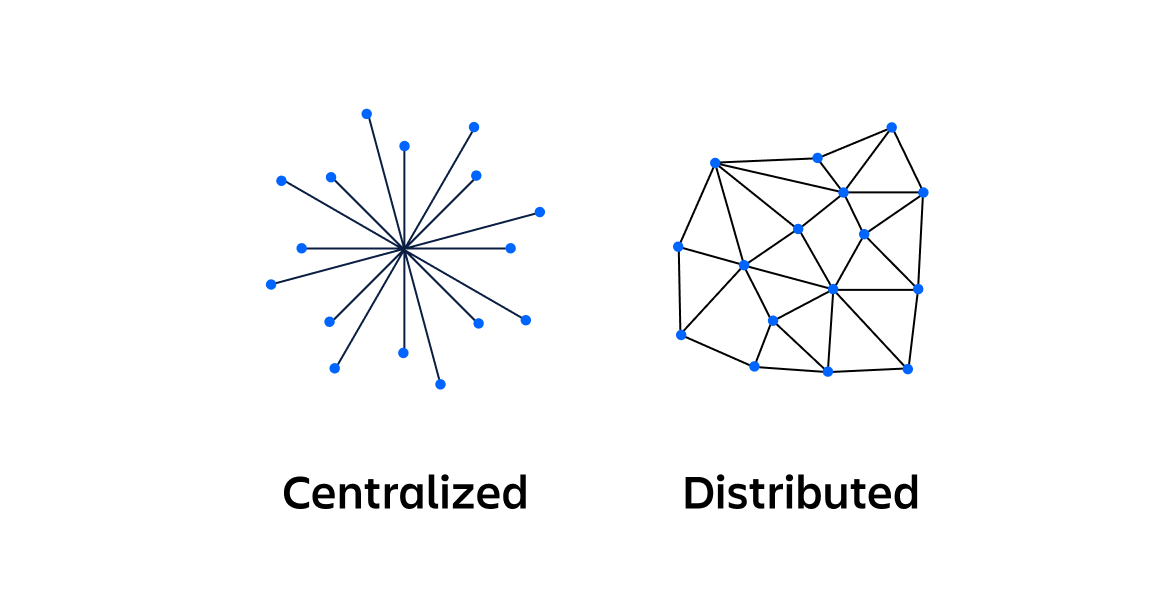

No universo dos sistemas distribuídos, a eficiência e a escalabilidade são desafios constantes. À medida que as aplicações crescem em complexidade e volume de dados, torna-se crucial implementar estratégias robustas para distribuir carga e gerenciar recursos de forma eficaz. Neste contexto, o hashing consistente emerge como uma técnica poderosa, oferecendo soluções elegantes para problemas de balanceamento de carga e particionamento de dados.

Este artigo mergulha profundamente na implementação e otimização de algoritmos de hashing consistente, explorando suas aplicações práticas e impacto em sistemas distribuídos modernos. Vamos além da teoria básica, examinando implementações avançadas, trade-offs de desempenho e casos de uso do mundo real.

Fundamentos do Hashing Consistente

Antes de nos aprofundarmos nas implementações avançadas, é essencial compreender os princípios fundamentais do hashing consistente.

O Problema do Hashing Tradicional

Em sistemas distribuídos, frequentemente precisamos mapear itens (como chaves de cache ou dados) para um conjunto de servidores ou nós. O método tradicional de hashing, como usar hash(key) % n, onde n é o número de servidores, apresenta problemas significativos quando o número de servidores muda. Uma alteração em n resulta em um remapeamento massivo de chaves, causando uma redistribuição de dados em larga escala e potencial sobrecarga do sistema.

A Solução do Hashing Consistente

O hashing consistente resolve este problema mapeando tanto as chaves quanto os servidores para um espaço circular de hash (geralmente representado como um anel de 0 a 2^32 - 1). As chaves são atribuídas ao servidor mais próximo no sentido horário no anel. Quando um servidor é adicionado ou removido, apenas uma fração das chaves precisa ser remapeada, minimizando a redistribuição de dados.

Implementação Básica do Hashing Consistente

Vamos começar com uma implementação básica em Python para ilustrar o conceito:

import hashlib

class ConsistentHash:

def __init__(self, nodes=None, virtual_nodes=100):

self.virtual_nodes = virtual_nodes

self.ring = {}

self.sorted_keys = []

if nodes:

for node in nodes:

self.add_node(node)

def add_node(self, node):

for i in range(self.virtual_nodes):

key = self._hash(f"{node}:{i}")

self.ring[key] = node

self.sorted_keys.append(key)

self.sorted_keys.sort()

def remove_node(self, node):

for i in range(self.virtual_nodes):

key = self._hash(f"{node}:{i}")

del self.ring[key]

self.sorted_keys.remove(key)

def get_node(self, key):

if not self.ring:

return None

hash_key = self._hash(key)

for node_key in self.sorted_keys:

if node_key >= hash_key:

return self.ring[node_key]

return self.ring[self.sorted_keys[0]]

def _hash(self, key):

return hashlib.md5(key.encode()).hexdigest()

# Exemplo de uso

ch = ConsistentHash(["node1", "node2", "node3"])

print(ch.get_node("object1")) # Retorna o nó responsável por "object1"

ch.add_node("node4")

print(ch.get_node("object1")) # Pode retornar o mesmo nó ou um diferente

Esta implementação básica ilustra os princípios fundamentais do hashing consistente, mas há várias otimizações e considerações avançadas que podemos explorar para melhorar o desempenho e a distribuição.

Otimizações Avançadas

1. Distribuição Uniforme com Nós Virtuais

Um desafio comum no hashing consistente é garantir uma distribuição uniforme das chaves entre os nós físicos. A técnica de nós virtuais, já introduzida na implementação básica, pode ser refinada para melhorar a uniformidade.

import mmh3 # MurmurHash3, uma função de hash mais rápida e com melhor distribuição

class OptimizedConsistentHash:

def __init__(self, nodes=None, virtual_nodes=1000):

self.virtual_nodes = virtual_nodes

self.ring = {}

self.nodes = set()

if nodes:

for node in nodes:

self.add_node(node)

def add_node(self, node):

self.nodes.add(node)

for i in range(self.virtual_nodes):

key = self._hash(f"{node}:{i}")

self.ring[key] = node

def remove_node(self, node):

self.nodes.remove(node)

for i in range(self.virtual_nodes):

key = self._hash(f"{node}:{i}")

del self.ring[key]

def get_node(self, key):

if not self.ring:

return None

hash_key = self._hash(key)

node_keys = sorted(self.ring.keys())

for node_key in node_keys:

if node_key >= hash_key:

return self.ring[node_key]

return self.ring[node_keys[0]]

def _hash(self, key):

return mmh3.hash(key)

# Análise de distribuição

ch = OptimizedConsistentHash(["node1", "node2", "node3", "node4"])

distribution = {node: 0 for node in ch.nodes}

for i in range(100000):

node = ch.get_node(f"key{i}")

distribution[node] += 1

print("Distribuição:", distribution)

Nesta implementação otimizada, aumentamos o número de nós virtuais e usamos MurmurHash3 para uma melhor distribuição. A análise de distribuição ajuda a verificar se as chaves estão sendo distribuídas uniformemente entre os nós.

2. Balanceamento de Carga Dinâmico

Em cenários do mundo real, os nós podem ter capacidades diferentes ou cargas variáveis. Podemos estender nosso algoritmo para considerar a carga atual de cada nó:

class DynamicLoadBalancedHash:

def __init__(self, nodes=None):

self.nodes = {}

self.sorted_keys = []

if nodes:

for node, capacity in nodes.items():

self.add_node(node, capacity)

def add_node(self, node, capacity):

self.nodes[node] = {"capacity": capacity, "load": 0}

self._update_ring()

def remove_node(self, node):

del self.nodes[node]

self._update_ring()

def _update_ring(self):

self.sorted_keys = sorted(

[(self._hash(node), node) for node in self.nodes],

key=lambda x: x[0]

)

def get_node(self, key):

if not self.nodes:

return None

hash_key = self._hash(key)

for node_hash, node in self.sorted_keys:

if node_hash >= hash_key and self.nodes[node]["load"] < self.nodes[node]["capacity"]:

self.nodes[node]["load"] += 1

return node

# Se nenhum nó adequado for encontrado, use o menos carregado

return min(self.nodes, key=lambda x: self.nodes[x]["load"] / self.nodes[x]["capacity"])

def _hash(self, key):

return mmh3.hash(str(key))

# Exemplo de uso com capacidades diferentes

nodes = {"node1": 100, "node2": 200, "node3": 300}

dlbh = DynamicLoadBalancedHash(nodes)

for i in range(1000):

dlbh.get_node(f"key{i}")

for node, info in dlbh.nodes.items():

print(f"{node}: {info['load']}/{info['capacity']}")

Esta implementação considera a capacidade e a carga atual de cada nó, permitindo um balanceamento de carga mais sofisticado.

Aplicações Práticas e Considerações de Design

Caches Distribuídos

O hashing consistente é amplamente utilizado em caches distribuídos como Memcached e Redis Cluster. Ele permite que o cache seja escalado horizontalmente com mínima redistribuição de dados.

Particionamento de Dados em Bancos NoSQL

Bancos de dados NoSQL como Cassandra e DynamoDB usam hashing consistente para distribuir dados entre nós. Isso facilita a adição ou remoção de nós sem causar uma reorganização massiva dos dados.

Considerações de Design

Escolha da Função de Hash: A qualidade da função de hash é crucial. MurmurHash3 é uma escolha popular devido à sua velocidade e boa distribuição.

Número de Nós Virtuais: Aumentar o número de nós virtuais melhora a distribuição, mas aumenta o uso de memória e o tempo de busca. É necessário encontrar um equilíbrio.

Consistência vs. Disponibilidade: Em sistemas distribuídos, muitas vezes é necessário fazer trade-offs entre consistência e disponibilidade (teorema CAP). O hashing consistente pode ajudar a gerenciar esses trade-offs, mas não os elimina completamente.

Replicação: Para aumentar a disponibilidade, muitos sistemas replicam dados em múltiplos nós. O hashing consistente pode ser estendido para suportar replicação, mapeando cada chave para múltiplos nós consecutivos no anel.

Implementação de Alta Performance em C++

Para cenários que exigem máximo desempenho, uma implementação em C++ pode oferecer vantagens significativas. Aqui está um exemplo de uma implementação otimizada:

#include <iostream>

#include <vector>

#include <unordered_map>

#include <algorithm>

#include <cstdint>

#include <string>

#include <functional>

class ConsistentHash {

private:

std::vector<std::pair<uint32_t, std::string>> ring;

std::unordered_map<std::string, int> node_count;

int virtual_nodes;

std::hash<std::string> hasher;

uint32_t hash(const std::string& key) {

return hasher(key);

}

public:

ConsistentHash(int virtual_nodes = 100) : virtual_nodes(virtual_nodes) {}

void add_node(const std::string& node) {

for (int i = 0; i < virtual_nodes; ++i) {

std::string key = node + ":" + std::to_string(i);

ring.emplace_back(hash(key), node);

}

std::sort(ring.begin(), ring.end());

node_count[node]++;

}

void remove_node(const std::string& node) {

auto new_end = std::remove_if(ring.begin(), ring.end(),

[&node](const auto& pair) { return pair.second == node; });

ring.erase(new_end, ring.end());

node_count.erase(node);

}

std::string get_node(const std::string& key) {

if (ring.empty()) return "";

uint32_t hash_key = hash(key);

auto it = std::lower_bound(ring.begin(), ring.end(), std::make_pair(hash_key, std::string()));

if (it == ring.end()) it = ring.begin();

return it->second;

}

void print_distribution() {

std::unordered_map<std::string, int> dist;

for (const auto& pair : ring) {

dist[pair.second]++;

}

for (const auto& pair : dist) {

std::cout << pair.first << ": " << pair.second << " virtual nodes\\\\n";

}

}

};

int main() {

ConsistentHash ch(1000);

ch.add_node("node1");

ch.add_node("node2");

ch.add_node("node3");

ch.print_distribution();

std::cout << "Key1 -> " << ch.get_node("Key1") << std::endl;

std::cout << "Key2 -> " << ch.get_node("Key2") << std::endl;

std::cout << "Key3 -> " << ch.get_node("Key3") << std::endl;

ch.remove_node("node2");

std::cout << "After removing node2:\\\\n";

ch.print_distribution();

return 0;

}

Esta implementação em C++ oferece várias otimizações:

Uso de

std::vectorestd::unordered_mappara armazenamento eficiente.Algoritmos de busca otimizados com

std::lower_bound.Hashing rápido usando a função de hash padrão do C++.

Conclusão

O hashing consistente é uma técnica fundamental em sistemas distribuídos modernos, oferecendo soluções elegantes para problemas de balanceamento de carga e particionamento de dados. Ao implementar e otimizar algoritmos de hashing consistente, podemos criar sistemas mais escaláveis, resilientes e eficientes.

Neste artigo, exploramos desde implementações básicas até otimizações avançadas, incluindo distribuição uniforme, balanceamento de carga dinâmico e implementações de alta performance. Também discutimos aplicações práticas e considerações de design cruciais para engenheiros de sistemas distribuídos.

À medida que os sistemas continuam a crescer em escala e complexidade, técnicas como o hashing consistente se tornam cada vez mais importantes. Dominar esses conceitos e suas implementações é essencial para qualquer engenheiro de software ou arquiteto de sistemas que trabalhe com aplicações distribuídas em larga escala.

Lembre-se de que, embora o hashing consistente ofereça muitas vantagens, ele não é uma solução universal. Cada sistema tem suas próprias necessidades e restrições, e é importante avaliar cuidadosamente as opções disponíveis e fazer os trade-offs apropriados para cada caso específico.

Continuar explorando e experimentando com essas técnicas é fundamental para se manter na vanguarda do desenvolvimento de sistemas distribuídos. Feliz codificação!