No cenário atual de Big Data e Internet das Coisas (IoT), a capacidade de processar e aprender a partir de grandes fluxos de dados em tempo real tornou-se crucial. Os algoritmos de aprendizado de máquina online surgiram como uma solução eficaz para lidar com esses desafios, permitindo a atualização contínua dos modelos à medida que novos dados chegam, sem a necessidade de retreinamento completo.

Neste artigo, vamos mergulhar profundamente na implementação e otimização de três algoritmos populares de aprendizado de máquina online: Perceptron, Passive-Aggressive e algoritmos baseados em gradiente estocástico (SGD). Analisaremos suas características, vantagens e desafios no contexto de processamento de grandes fluxos de dados em tempo real.

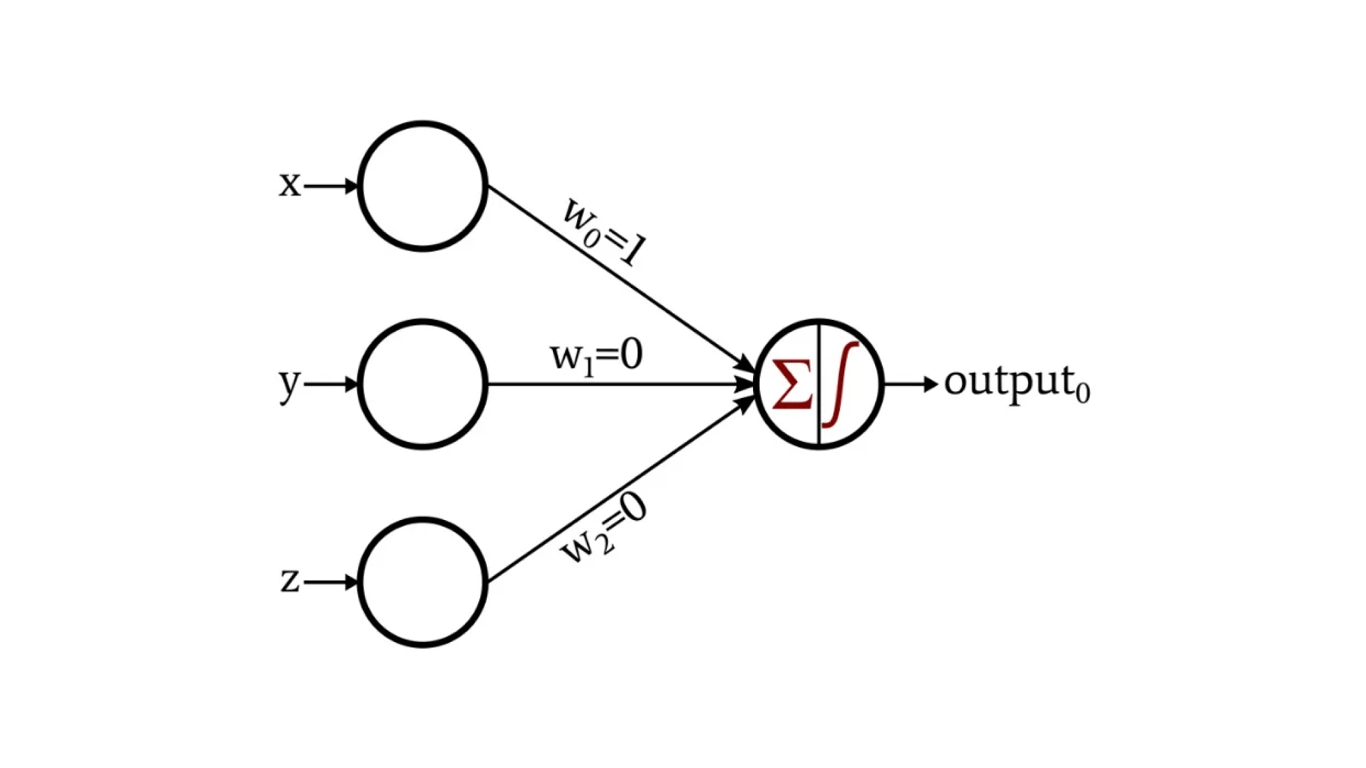

1. Perceptron Online

O Perceptron é um dos algoritmos mais antigos e fundamentais em aprendizado de máquina. Sua versão online é particularmente útil para classificação binária em fluxos de dados contínuos.

1.1 Implementação Básica

Vamos começar com uma implementação básica do Perceptron Online em Python:

import numpy as np

class OnlinePerceptron:

def __init__(self, n_features, learning_rate=0.01):

self.weights = np.zeros(n_features)

self.bias = 0

self.learning_rate = learning_rate

def predict(self, x):

return 1 if np.dot(self.weights, x) + self.bias > 0 else 0

def update(self, x, y):

y_pred = self.predict(x)

if y_pred != y:

self.weights += self.learning_rate * (y - y_pred) * x

self.bias += self.learning_rate * (y - y_pred)

def fit(self, X, y, epochs=1):

for _ in range(epochs):

for xi, yi in zip(X, y):

self.update(xi, yi)

Esta implementação básica atualiza os pesos e o viés sempre que uma previsão incorreta é feita. No entanto, ela pode ser sensível a outliers e ruído nos dados.

1.2 Otimização: Perceptron com Margem

Uma melhoria significativa pode ser alcançada introduzindo uma margem, similar ao SVM (Support Vector Machine). Isso torna o algoritmo mais robusto a ruídos:

class MarginPerceptron(OnlinePerceptron):

def __init__(self, n_features, learning_rate=0.01, margin=1.0):

super().__init__(n_features, learning_rate)

self.margin = margin

def update(self, x, y):

y = 2*y - 1 # Convert 0/1 to -1/+1

score = y * (np.dot(self.weights, x) + self.bias)

if score < self.margin:

self.weights += self.learning_rate * y * x

self.bias += self.learning_rate * y

Esta versão com margem atualiza os pesos não apenas quando há uma classificação incorreta, mas também quando a previsão está correta, porém com uma margem insuficiente.

2. Algoritmo Passive-Aggressive

O algoritmo Passive-Aggressive (PA) é uma extensão do Perceptron que ajusta os pesos de forma mais agressiva quando ocorrem erros, mas permanece passivo quando a previsão está correta.

2.1 Implementação Básica

Aqui está uma implementação básica do algoritmo PA:

class PassiveAggressive:

def __init__(self, n_features, C=1.0):

self.weights = np.zeros(n_features)

self.bias = 0

self.C = C

def predict(self, x):

return 1 if np.dot(self.weights, x) + self.bias > 0 else 0

def update(self, x, y):

y = 2*y - 1 # Convert 0/1 to -1/+1

loss = max(0, 1 - y * (np.dot(self.weights, x) + self.bias))

if loss > 0:

norm = np.linalg.norm(x)**2

step_size = min(self.C, loss / norm) if norm != 0 else 0

self.weights += step_size * y * x

self.bias += step_size * y

def fit(self, X, y, epochs=1):

for _ in range(epochs):

for xi, yi in zip(X, y):

self.update(xi, yi)

O algoritmo PA calcula um tamanho de passo adaptativo baseado na perda atual e na norma do vetor de características.

2.2 Otimização: Variantes PA-I e PA-II

Existem duas variantes principais do algoritmo PA que oferecem diferentes trade-offs entre agressividade e estabilidade:

class PAI(PassiveAggressive):

def update(self, x, y):

y = 2*y - 1

loss = max(0, 1 - y * (np.dot(self.weights, x) + self.bias))

if loss > 0:

norm = np.linalg.norm(x)**2

step_size = loss / (norm + 1/(2*self.C))

self.weights += step_size * y * x

self.bias += step_size * y

class PAII(PassiveAggressive):

def update(self, x, y):

y = 2*y - 1

loss = max(0, 1 - y * (np.dot(self.weights, x) + self.bias))

if loss > 0:

norm = np.linalg.norm(x)**2

step_size = loss / (norm + 1/(2*self.C))

self.weights += step_size * y * x

self.bias += step_size * y

PA-I e PA-II introduzem diferentes formas de regularização, permitindo um melhor controle sobre a agressividade das atualizações.

3. Algoritmos Baseados em Gradiente Estocástico (SGD)

Os algoritmos baseados em SGD são amplamente utilizados em aprendizado online devido à sua eficiência e flexibilidade.

3.1 Implementação Básica: SGD para Regressão Logística

Vamos implementar um classificador de regressão logística online usando SGD:

class SGDLogisticRegression:

def __init__(self, n_features, learning_rate=0.01):

self.weights = np.zeros(n_features)

self.bias = 0

self.learning_rate = learning_rate

def _sigmoid(self, z):

return 1 / (1 + np.exp(-z))

def predict_proba(self, x):

return self._sigmoid(np.dot(self.weights, x) + self.bias)

def predict(self, x):

return 1 if self.predict_proba(x) > 0.5 else 0

def update(self, x, y):

y_pred = self.predict_proba(x)

error = y - y_pred

self.weights += self.learning_rate * error * x

self.bias += self.learning_rate * error

def fit(self, X, y, epochs=1):

for _ in range(epochs):

for xi, yi in zip(X, y):

self.update(xi, yi)

Esta implementação usa a função sigmoide para calcular probabilidades e atualiza os pesos com base no erro de previsão.

3.2 Otimização: Momentum e Aprendizado Adaptativo

Podemos melhorar o SGD incorporando momentum e taxas de aprendizado adaptativas:

class AdaptiveSGD(SGDLogisticRegression):

def __init__(self, n_features, learning_rate=0.01, momentum=0.9, epsilon=1e-8):

super().__init__(n_features, learning_rate)

self.momentum = momentum

self.epsilon = epsilon

self.velocity = np.zeros_like(self.weights)

self.squared_grad = np.zeros_like(self.weights)

def update(self, x, y):

y_pred = self.predict_proba(x)

error = y - y_pred

grad = error * x

# Momentum

self.velocity = self.momentum * self.velocity + (1 - self.momentum) * grad

# RMSprop

self.squared_grad = 0.9 * self.squared_grad + 0.1 * grad**2

adjusted_grad = grad / (np.sqrt(self.squared_grad) + self.epsilon)

self.weights += self.learning_rate * (self.velocity + adjusted_grad)

self.bias += self.learning_rate * error

Esta versão otimizada combina momentum para acelerar a convergência em direções consistentes e RMSprop para adaptar as taxas de aprendizado a cada parâmetro.

4. Análise Comparativa

Agora que implementamos e otimizamos esses três algoritmos, vamos compará-los em termos de:

Velocidade de convergência

Robustez a ruídos

Desempenho em diferentes tipos de dados

Escalabilidade para grandes fluxos de dados

4.1 Velocidade de Convergência

O Perceptron tende a convergir mais lentamente, especialmente em conjuntos de dados não linearmente separáveis. O Passive-Aggressive geralmente converge mais rapidamente devido às suas atualizações agressivas. Os algoritmos baseados em SGD, especialmente com otimizações como momentum e aprendizado adaptativo, geralmente oferecem um bom equilíbrio entre velocidade e estabilidade.

4.2 Robustez a Ruídos

O Perceptron com margem e o Passive-Aggressive são geralmente mais robustos a ruídos do que o Perceptron básico. Os algoritmos baseados em SGD podem ser sensíveis a outliers, mas técnicas como regularização L1/L2 podem melhorar sua robustez.

4.3 Desempenho em Diferentes Tipos de Dados

O Perceptron e o Passive-Aggressive são mais adequados para problemas linearmente separáveis. Os algoritmos baseados em SGD, especialmente quando usados com funções de perda não lineares como a regressão logística, podem lidar melhor com fronteiras de decisão não lineares.

4.4 Escalabilidade para Grandes Fluxos de Dados

Todos os três algoritmos são adequados para grandes fluxos de dados devido à sua natureza online. No entanto, os algoritmos baseados em SGD geralmente oferecem melhor escalabilidade devido à sua flexibilidade e eficiência computacional.

Conclusão

Neste artigo, exploramos a implementação e otimização de três importantes algoritmos de aprendizado de máquina online: Perceptron, Passive-Aggressive e algoritmos baseados em SGD. Cada um desses algoritmos tem suas próprias forças e fraquezas, e a escolha entre eles dependerá das características específicas do problema e dos dados.

O Perceptron oferece simplicidade e interpretabilidade, mas pode ser limitado em problemas complexos. O Passive-Aggressive proporciona atualizações mais agressivas e geralmente converge mais rapidamente. Os algoritmos baseados em SGD oferecem grande flexibilidade e eficiência, especialmente quando otimizados com técnicas como momentum e aprendizado adaptativo.

Ao trabalhar com grandes fluxos de dados em tempo real, é crucial considerar não apenas o desempenho do algoritmo, mas também sua eficiência computacional e capacidade de adaptação a mudanças nos padrões dos dados. A implementação eficiente desses algoritmos, juntamente com técnicas de engenharia de features e pré-processamento de dados, pode levar a sistemas de aprendizado online robustos e eficazes.

À medida que o campo do aprendizado de máquina continua a evoluir, podemos esperar ver mais avanços em algoritmos online, incluindo abordagens híbridas que combinam os pontos fortes de diferentes métodos. O desafio contínuo será equilibrar a velocidade de aprendizado, a adaptabilidade e a eficiência computacional para lidar com os crescentes volumes e complexidades dos dados do mundo real.